A mesterséges intelligencia korszakában egyre nagyobb teret hódítanak az automatikusan generált szövegek - ám ezzel együtt újfajta problémák is megjelentek a tudományos publikációk világában - írta a theconversation.com.

Az egyik legmeglepőbb jelenség a "vegetative electron microscopy" kifejezés elterjedése, amely bár első hallásra komolynak tűnik, valójában teljesen értelmetlen. A szófordulat úgynevezett "digitális fosszíliaként" kezd terjedni, rámutatva arra, hogy miként képesek az AI-modellek véletlen hibákat bebetonozni a kollektív ismeretanyagokba.

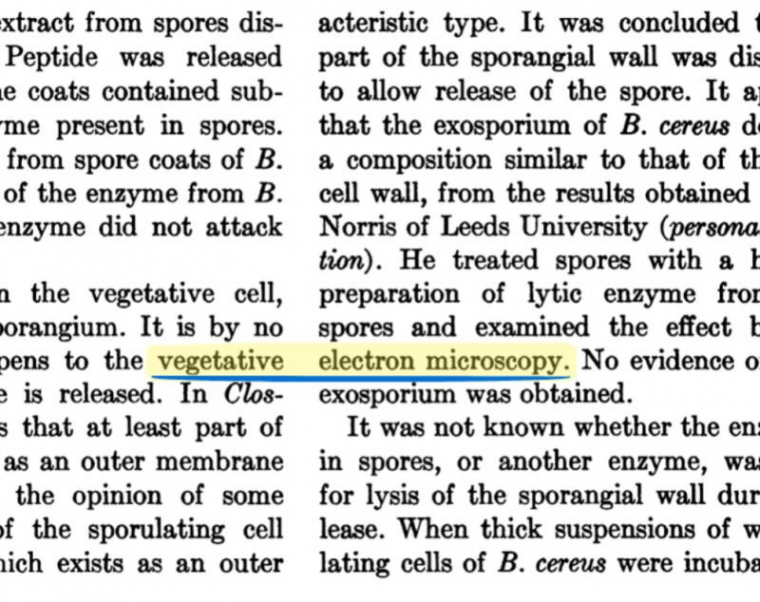

A történet az 1950-es évekbe nyúlik vissza, amikor két tudományos cikket digitalizáltak a Bacteriological Reviews című folyóiratból. A szkennelés során egy technikai hiba miatt a "vegetative" szó egy másik oszlopból származó "electron" szóval keveredett, így megszületett a fiktív "vegetative electron microscopy" kifejezés.

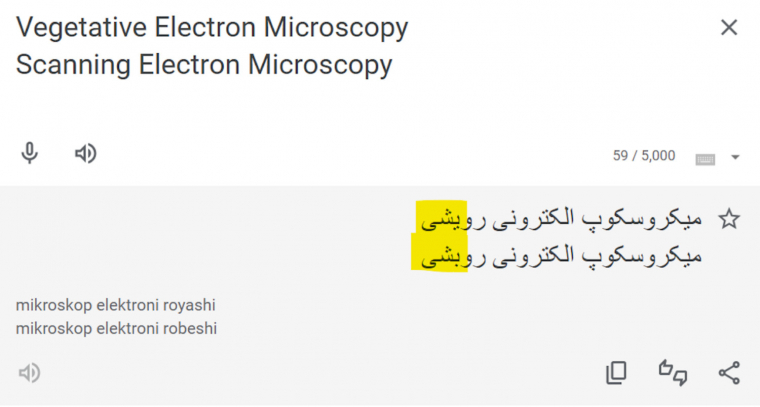

Évtizedekkel később ez a hibás szófordulat feltűnt néhány iráni származású tudományos cikkben. Valószínűleg egy fordítási tévedés is közrejátszott, mivel a perzsa nyelvben a "vegetative" és a "scanning" szavakat csupán egyetlen pont különbözteti meg. Az így létrejött fordítási hiba tovább erősítette a téves kifejezés használatát.

A 2020-as évekre a "vegetative electron microscopy" már több tucat tudományos cikkben szerepelt, és egyes esetekben a kiadók kénytelenek voltak visszavonni vagy javítani az érintett tanulmányokat. A kérdés ekkor vált igazán aggasztóvá: hogyan terjedhetett el ilyen mértékben egy teljesen értelmetlen kifejezés?

A válasz a mesterséges intelligencia szövegalkotó modelljeiben keresendő. A kutatók megvizsgálták, hogyan reagálnak különböző generatív nyelvi modellek - például az OpenAI GPT-3 és GPT-4, illetve az Anthropic Claude 3.5 - a korabeli szövegrészletekre. Kiderült, hogy a modernebb modellek rendszeresen és következetesen a hibás kifejezéssel egészítik ki a szöveget, míg a korábbi modellek, mint a GPT-2 vagy a BERT, nem mutatták ezt a mintázatot.

A hiba forrásaként azonosították a CommonCrawl nevű nyílt internetes szövegbázist, amelyet sok AI-modell is használ tanulási alapként. Mivel ez a dataset hatalmas méretű, a hibák felismerése és javítása szinte lehetetlen, különösen a kisebb kutatócsoportok számára.

A történet azonban túlmutat egyetlen kifejezésen. A "vegetative electron microscopy" esete rámutat arra, milyen veszélyeket hordoz az, amikor az AI rendszerek nem csak adatokat, hanem hibákat is megtanulnak és terjesztenek. Az értelmetlen kifejezések megnehezítik a lektorálási folyamatokat, és zavarokat okoznak a tudományos publikációkban.

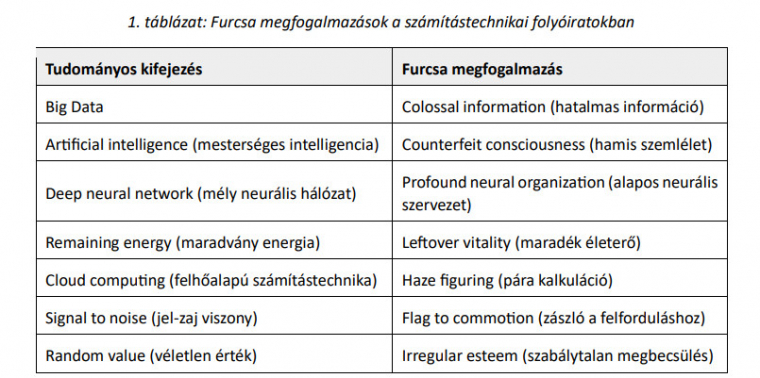

Ráadásul az AI által generált cikkek trükköket is alkalmaznak az automatikus ellenőrző rendszerek kijátszására. Jó példa erre a "tortured phrases" (furcsa kifejezések) jelenség, amikor alternatív, de hibás szókapcsolatokat használnak (pl. "counterfeit consciousness" a mesterséges intelligencia helyett).

Forrás: Furcsa megfogalmazások a számítástechnikai folyóiratokban - Sasvári Péter - érdemes a linken lévő publikációt elolvasni!

Az ilyen típusú hibás digitális fosszíliák, mint a "vegetative electron microscopy", hasonlóan a régi, de valódi szakzsargonhoz, idővel beépülhetnek a tudományos ismerettárba, ha nem észlelik őket időben. És mivel a mesterséges intelligenciát már számos kutató és szerző is használja, ezek a hibák tovább szaporodhatnak.

A megoldás nem egyszerű, de néhány irányvonal már körvonalazódik:

- Átláthatóbb AI-fejlesztésre van szükség, beleértve a feltanító adatok nyilvánosságát.

- Tudatosabb szerkesztői és lektori munka kell, különösen az AI által generált tartalmak esetében.

- Fejlettebb szűrő- és ellenőrző eszközökre van szükség, amelyek nem csak ismert hibákat, hanem új mintázatokat is képesek kiszűrni.